在现代工业自动化向智能化转型的进程中,3D视觉引导技术正逐渐从辅助性工具演变为核心使能技术。它超越了传统2D视觉的平面局限,通过主动或被动方式精确获取物体的三维空间信息,从而实现对复杂场景的深度感知、位姿解算与智能决策。本文旨在对3D视觉引导的技术内核、关键挑战及其系统级应用价值进行深入解析。

一、 技术内核:从数据采集到空间理解

3D视觉引导系统的技术链始于三维数据的精确获取。主流技术路线主要分为三类:

光学三角测距法:以结构光与激光轮廓测量为代表。结构光通过将特定编码的光栅图案投射至物体表面,利用相机捕捉变形条纹,通过相位解算实现高精度三维重建,适用于静态、高精度场景。激光轮廓测量则通过激光线扫描,结合运动轴,快速获取物体截面轮廓,累积形成三维点云,适用于连续运动物体的在线检测与引导。

飞行时间法:通过测量光脉冲或调制光波从发射到反射接收的时间差,直接计算深度信息。其优势在于测量距离远、抗干扰能力强,适用于大尺度场景的导航与避障,但在绝对精度和细节分辨上常面临挑战。

多视角立体视觉:模仿人眼双目视差原理,利用两个或多个相机从不同视角拍摄同一场景,通过特征匹配与三角测量计算深度。其系统校准复杂,计算量较大,但在自然光条件下对无纹理物体的匹配存在固有难题。近年来,结合深度学习辅助立体匹配,其鲁棒性得到显著提升。

获取原始点云数据后,点云预处理与特征提取成为关键桥梁。这包括滤波去噪、背景分割、点云配准与关键几何特征的提取。随后进入核心的3D识别与位姿估计算法阶段。传统方法依赖于基于模板的匹配或基于特征的配准。而当前的前沿研究深度结合深度学习,通过训练神经网络直接从未经处理的点云或融合RGB-D数据中,端到端地预测物体的类别与六自由度位姿,显著提升了对杂乱场景、部分遮挡及形变物体的识别鲁棒性。

二、 核心挑战与精度权衡解析

尽管技术进步显著,3D视觉引导在工业级部署中仍面临一系列深层挑战:

精度、速度与成本的“不可能三角”:高精度往往依赖于高分辨率传感器与复杂算法,导致数据量大、处理速度受限、系统成本高昂。工业现场需在毫米级乃至亚毫米级精度、每秒数次的引导频率与合理的投资回报之间取得精细平衡。

复杂环境的鲁棒性:工业现场的光照变化、反射表面、半透明材料、粉尘油污等,极易干扰光学测量,导致点云缺失或噪声剧增。这要求系统在硬件和软件算法层面进行协同优化。

动态场景与实时性要求:对于高速传送带上的随机抓取或机器人协同作业,系统需在极短周期内完成从图像采集、处理到机器人路径规划的全流程。这对传感器帧率、计算平台的算力以及通信接口的延迟提出了苛刻要求。

系统集成与校准的复杂性:将视觉传感器、机器人、运动控制单元无缝集成并维持长期稳定,是一个系统性工程。手眼校准的精度直接影响引导的绝对精度,而长期的机械振动、温度漂移可能使校准参数失效,需建立在线或定期校准机制。

三、 系统级价值与应用范式演进

3D视觉引导的价值远非单一技术突破,而在于其带来的系统级能力跃迁:

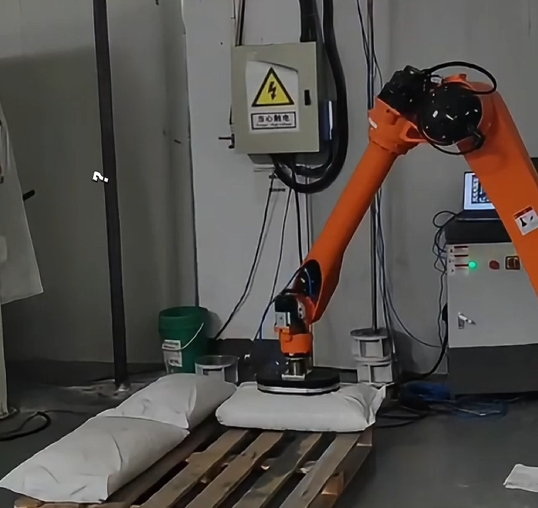

从“已知位置”到“未知随机”的作业能力:使机器人能够处理随意堆叠、非结构摆放的工件,极大提升了生产线的柔性与自动化范围。

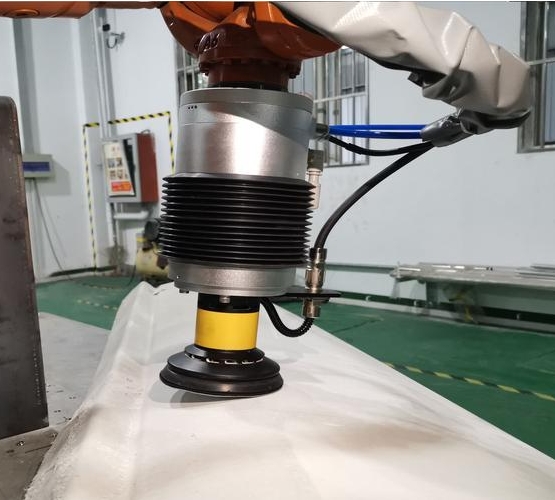

从“接触式”到“非接触式”的精密测量与引导:在精密装配中,可非接触式测量多个特征点的空间关系,引导机器人进行亚毫米级的自适应调整,补偿零件公差与夹具误差。

从“预设路径”到“实时感知反馈”的智能加工:在焊接、打磨、喷涂等领域,通过实时扫描工件三维形貌,可动态生成或修正加工轨迹,适应工件的个体差异与形变,确保工艺一致性。

其应用范式正从离散的“眼睛-大脑-手”单元,向网络化、协同化的全厂视觉感知层演进。多个3D视觉传感器可布置于生产线不同工位,形成协同感知网络,数据汇聚至统一的监控与分析平台,实现生产状态的全流程三维数字化映射,为质量控制、工艺优化与预测性维护提供深度数据支撑。

结论

综上所述,3D视觉引导技术正处于一个从实验室成熟走向工业深度部署的关键时期。其发展动力不再仅是传感器硬件的迭代,更依赖于计算机视觉算法、机器人学与人工智能的深度融合。未来的突破将聚焦于:开发更高效、更轻量的网络架构以实现边缘实时推理;构建大规模、高质量、面向工业场景的合成与真实三维数据集;以及发展自适应、自校准的智能系统,以降低部署门槛与维护成本。3D视觉引导作为智能制造的“智慧之眼”,其持续进化将深刻重塑自动化系统的感知与决策边界,驱动工业生产迈向更高层次的自主与灵活。